本文介绍了如何在 Obsidian 中使用本地 LLM 工具 LM Studio。

准备阶段

- 安装 Obsidian

- 安装 LM Studio

- 安装 Obsidian 插件:Text Generator

安装 LLM

打开 LM Studio,下载 Google’s Gemma 2B Instruct。

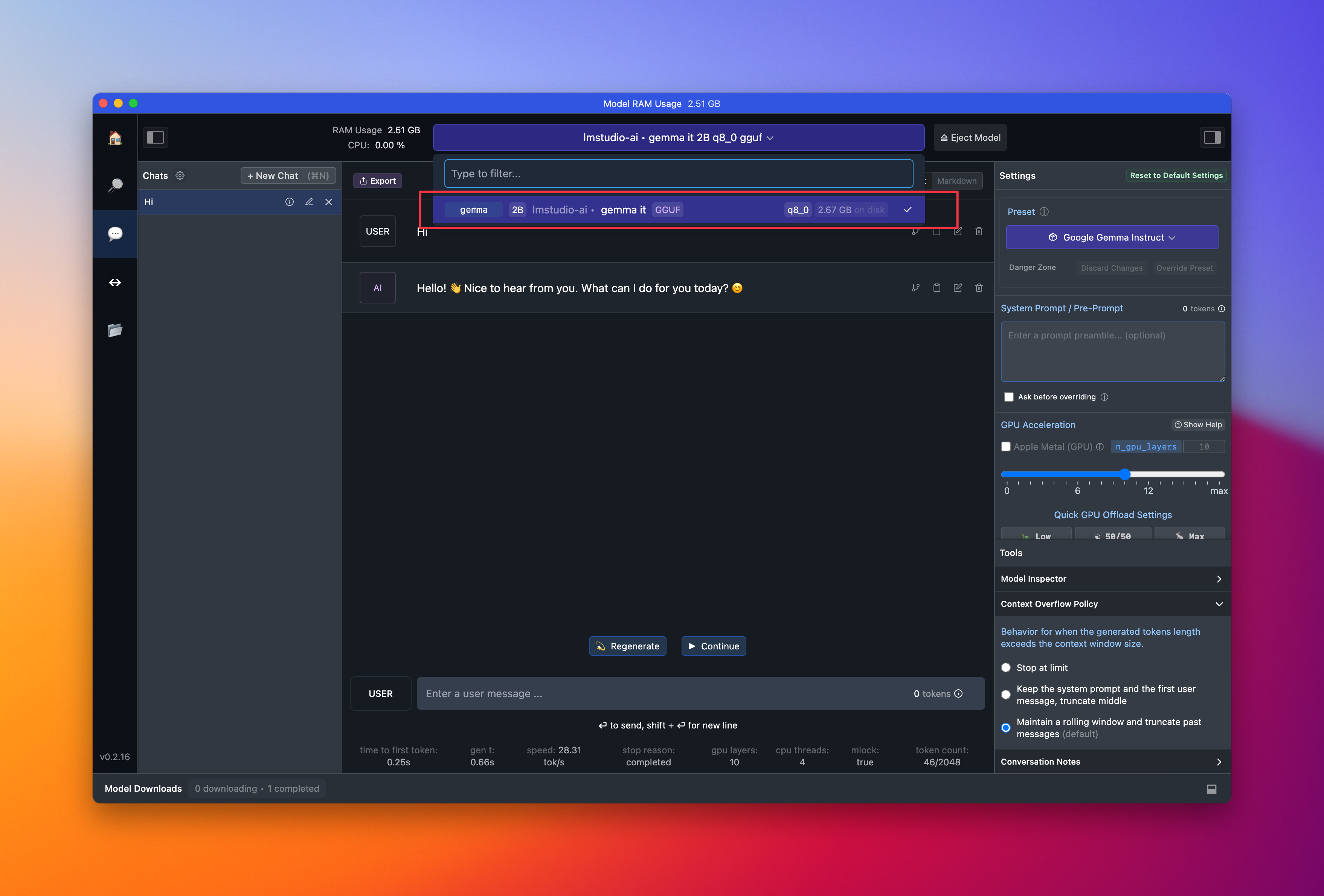

进入 Chats 界面(下图),并选择刚刚下载好的模型:Imstudio-ai • gemma it 2B q8_0 gguf。

在对话框中输入文字,测试模型是否能正常使用。

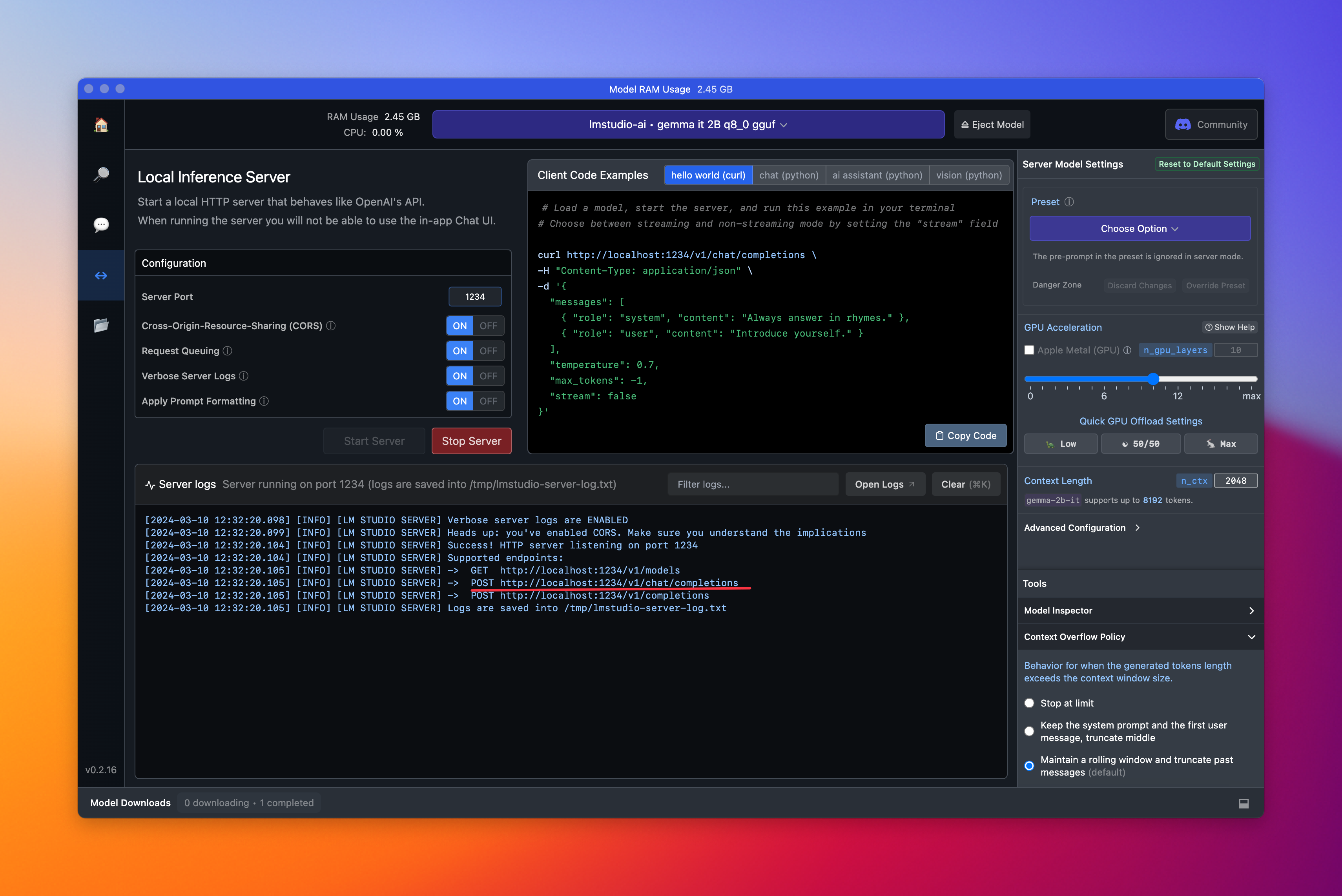

进入 Local Inference Server 界面,选择刚刚下载的模型,点击 Start Server。

共会生成三个 url,复制中间的: http://localhost:1234/v1/chat/completions

Obsidian-text generator

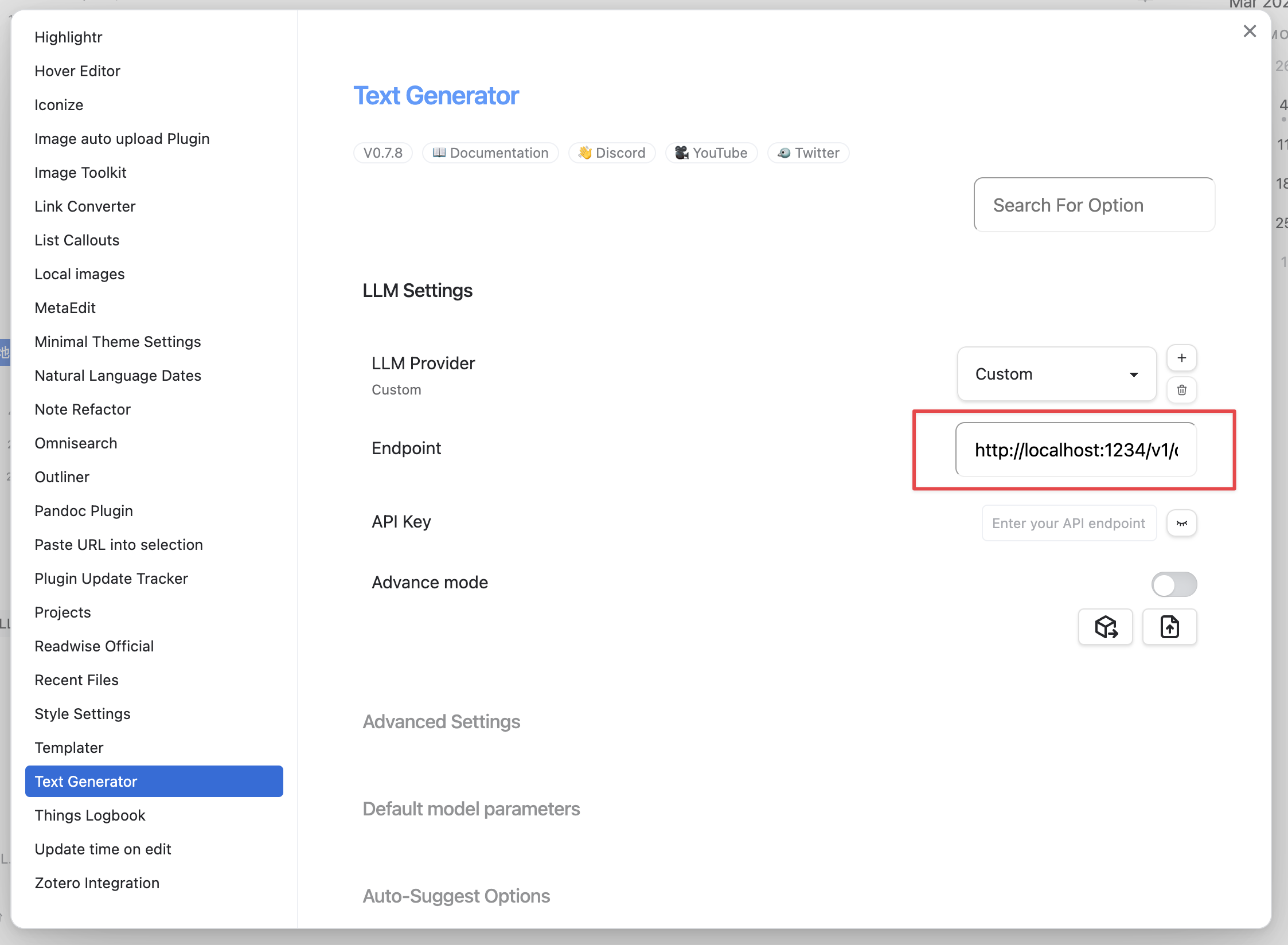

在 Obsidian 中打开 Text Generator 设置界面,LLM Provider 选择 Custom。

将刚刚复制的网址(http://localhost:1234/v1/chat/completions ),黏贴到 Endpoint 中。

体验

然后就能在 Obsidian 中使用 Gemma 2B Instruct 了。

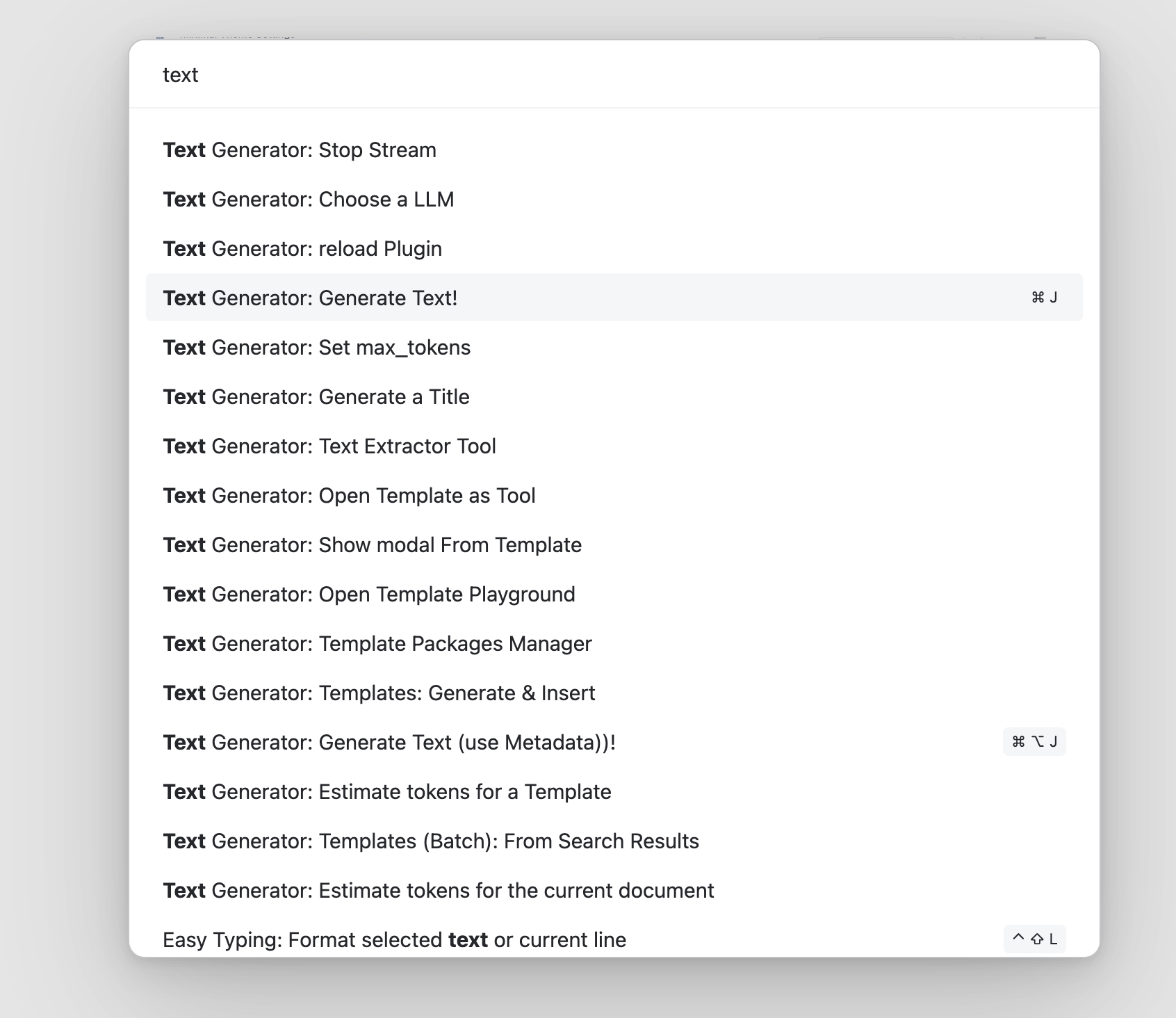

通过 Slash commands 或「cmd + P」打开启动器,输入 Text generator,能看到很多功能,常用的是:Text Generator: Generate Text!,默认快捷键是 cmd + J。

在任意笔记本中,输入问题,然后使用快捷键,即可启动本地模型,如下图。

另外,GPT4All 也是一个可本地使用的 LLM 工具,可以读取 Obsidian 的笔记本库,然后进行对话。

LM Studio 的可玩性真高呀,能嵌入Bob就更棒了。本地LLM模型真是值得期待!

确实,我也很期待这样的小插件

本地LLM,体积有多大?

我使用的这个是2gb。

感觉还行诶,比我预期中小一些,回头空了搞一个玩玩。这玩意儿实用么?🤔

能用ChatGPT的时候不会用到它,偶尔没网的时候应急一下还不错。

Obsidian 插件 Smart Connections,可以用本地大模型读取整个库,这个比较实用。打开文件的时候,可以推荐相关的笔记。

下载Model一直转圈,挂梯子也不行,求助!

模型是从 https://huggingface.co/ 上下载的,可以先看看梯子和 huggingface 的连接正常吗?

把 huggingface 的规则写在梯子里,走海外渠道,应该就能下载了。

huggingface连接正常,我用浏览器下载好了,请问应该放在哪个路径里呢?我用的Mac,没有改过设置。

哦,我刚在app里找到了 r

/Users/xxxx/.cache/lm-studio/models

Nice 呀!